Python 3.x

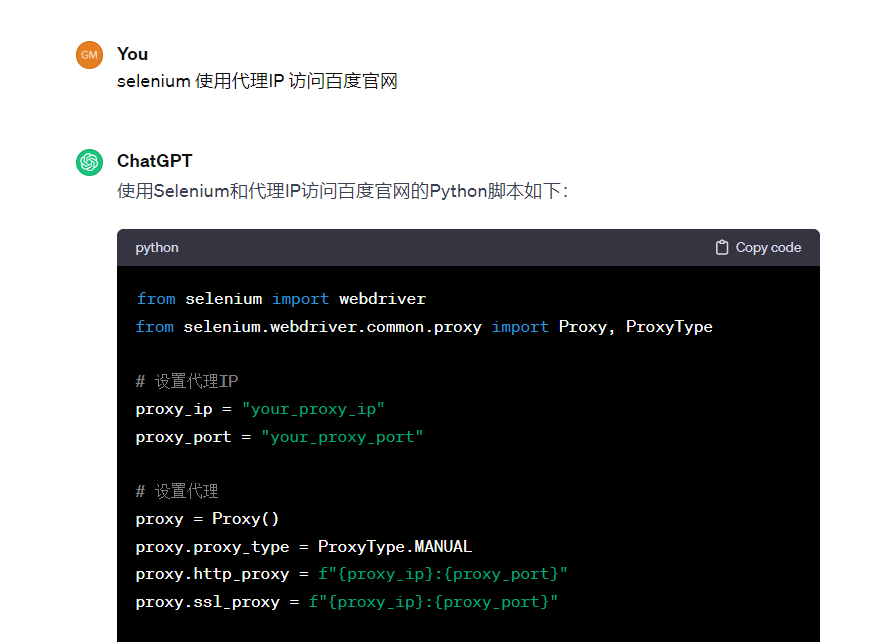

无账号密码使用 Selenium 实现 HTTP 代理最近一个朋友私聊了我一个问题,欧博allbetSelenium 如何使用代理 IP 进行爬虫,我心想这不是很简单,马上让 GPT 帮忙写一个:

让 GPT 帮我写一个

完整代码如下:

代码语言:Python

复制

from selenium import webdriver from selenium.webdriver.common.proxy import Proxy, ProxyType # 设置代理IP proxy_ip = "your_proxy_ip" proxy_port = "your_proxy_port" # 设置代理 proxy = Proxy() proxy.proxy_type = ProxyType.MANUAL proxy.http_proxy = f"{proxy_ip}:{proxy_port}" proxy.ssl_proxy = f"{proxy_ip}:{proxy_port}" # 配置浏览器选项 chrome_options = webdriver.ChromeOptions() chrome_options.add_argument('--proxy-server=http://{}:{}'.format(proxy_ip, proxy_port)) # 启动浏览器 driver = webdriver.Chrome(executable_path='path/to/chromedriver', options=chrome_options) # 访问百度官网 driver.get('https://www.baidu.com') # 在这里执行你的操作,比如查找元素、输入搜索关键词等 # 关闭浏览器 driver.quit()

GPT 提供的代码有时候并不准确,需要简单修改一下,运行成功:

代码语言:Python

复制

import time from selenium import webdriver from selenium.webdriver.chrome.service import Service # 设置代理IP proxy_ip = "127.0.0.1" proxy_port = "1080" # 配置浏览器选项 chrome_options = webdriver.ChromeOptions() chrome_options.add_argument('--proxy-server=http://{}:{}'.format(proxy_ip, proxy_port)) # 启动浏览器 chrome_service = Service("./chromedriver.exe") driver = webdriver.Chrome(service=chrome_service, options=chrome_options) # 访问百度官网 driver.get('https://www.baidu.com') # 在这里执行你的操作,比如查找元素、输入搜索关键词等 time.sleep(30) # 关闭浏览器 driver.quit()

无账号密码 Selenium 代理

万万没想到加上账号密码会难度升级 + N代码提供给朋友后,他突然回了一句,我的代理 IP 有账号密码,我心想这不简单,加上账号密码不就行了,然后我又转头把任务交给了 GPT,欧博百家乐GPT 又给我提供了一份代码(下面的代码经过微调,还是上面的问题):

GPT 提供的带账号密码的 HTTP 代理解决方案代码语言:Python

复制

import time from selenium import webdriver from selenium.webdriver.chrome.service import Service from selenium.webdriver.common.proxy import Proxy, ProxyType # 设置代理IP proxy_ip = "your_proxy_ip" proxy_port = "your_proxy_port" proxy_username = "your_proxy_username" proxy_password = "your_proxy_password" # 设置代理 proxy = Proxy() proxy.proxy_type = ProxyType.MANUAL proxy.http_proxy = f"{proxy_ip}:{proxy_port}" # 配置代理的认证信息 capabilities = webdriver.DesiredCapabilities.CHROME.copy() proxy_auth = f"{proxy_username}:{proxy_password}" capabilities['proxy'] = { 'httpProxy': proxy.http_proxy, 'ftpProxy': proxy.http_proxy, 'sslProxy': proxy.http_proxy, 'proxyType': 'MANUAL', 'socksUsername': proxy_username, 'socksPassword': proxy_password } # 配置浏览器选项 chrome_options = webdriver.ChromeOptions() chrome_options.add_experimental_option("excludeSwitches", ["enable-automation"]) chrome_options.add_argument('--proxy-server=http://{}:{}'.format(proxy_ip, proxy_port)) # 启动浏览器 chrome_service = Service("./chromedriver.exe") driver = webdriver.Chrome(service=chrome_service, options=chrome_options) # 访问百度官网 driver.get('https://www.baidu.com') # 在这里执行你的操作,比如查找元素、输入搜索关键词等 time.sleep(30) # 关闭浏览器 driver.quit()

代理 IP代码写好后不想改本地正常稳定使用的代理配置,使用了最近常使用的一个免费代理 IP (一连代理),支持主流的http/https/socks5协议,使用API快速拉取IP达到 50-300ms 响应时间,基本可以保证 99.99% 的IP可用性,有需要的小伙伴可以试试。

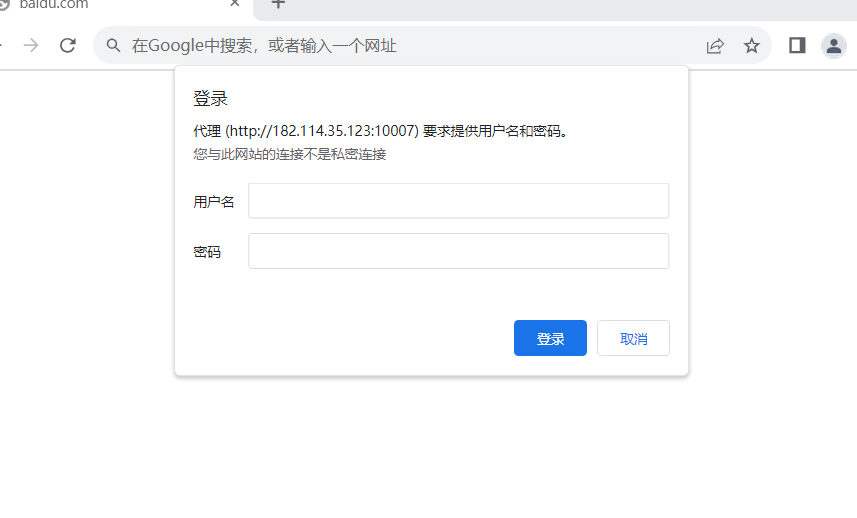

申请好代理IP后替换代码中账号密码然后点击运行,发现并没有通过认证:

为了排除是代理本身的问题,使用 curl 命令确认代理 IP 是否可以正常访问,说明是使用上的问题,经过15分钟的搜索和验证,最后让我找到了解决方案 - 使用 Selenium-Chrome-HTTP-Private-Proxy。

1、访问插件地址下载插件,放在项目目录中供使用

2、编写代码

代码语言:Python

复制

import time from selenium import webdriver from selenium.webdriver.chrome.options import Options from selenium.webdriver.chrome.service import Service def create_proxyauth_extension(proxy_host, proxy_port, proxy_username, proxy_password, scheme='http', plugin_path=None): """Proxy Auth Extension args: proxy_host (str): domain or ip address, ie proxy.domain.com proxy_port (int): port proxy_username (str): auth username proxy_password (str): auth password kwargs: scheme (str): proxy scheme, default http plugin_path (str): absolute path of the extension return str -> plugin_path """ import string import zipfile if plugin_path is None: plugin_path = 'Selenium-Chrome-HTTP-Private-Proxy.zip' manifest_json = """ { "version": "1.0.0", "manifest_version": 2, "name": "Chrome Proxy", "permissions": [ "proxy", "tabs", "unlimitedStorage", "storage", "<all_urls>", "webRequest", "webRequestBlocking" ], "background": { "scripts": ["background.js"] }, "minimum_chrome_version":"22.0.0" } """ background_js = string.Template( """ var config = { mode: "fixed_servers", rules: { singleProxy: { scheme: "${scheme}", host: "${host}", port: parseInt(${port}) }, bypassList: ["foobar.com"] } }; chrome.proxy.settings.set({value: config, scope: "regular"}, function() {}); function callbackFn(details) { return { authCredentials: { username: "${username}", password: "${password}" } }; } chrome.webRequest.onAuthRequired.addListener( callbackFn, {urls: ["<all_urls>"]}, ['blocking'] ); """ ).substitute( host=proxy_host, port=proxy_port, username=proxy_username, password=proxy_password, scheme=scheme, ) with zipfile.ZipFile(plugin_path, 'w') as zp: zp.writestr("manifest.json", manifest_json) zp.writestr("background.js", background_js) return plugin_path def configure_headless_browser(proxy_config): chrome_options = Options() chrome_options.add_argument("--start-maximized") proxyauth_plugin_path = create_proxyauth_extension( proxy_host=proxy_config[0], proxy_port=proxy_config[1], proxy_username=proxy_config[2], proxy_password=proxy_config[3] ) chrome_options.add_extension(proxyauth_plugin_path) # chrome_options.add_argument('--headless') # chrome_options.add_argument( # "user-agent='Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/95.0.4638.69 Safari/537.36'") chrome_service = Service("./chromedriver.exe") return webdriver.Chrome(service=chrome_service, options=chrome_options) # 设置代理IP proxy_config = ["175.153.142.127""", "10033", "9ER62CtIr", "fGGVvqedX"] # 启动浏览器 driver = configure_headless_browser(proxy_config) # 访问百度官网 driver.get('https://www.baidu.com') # 在这里执行你的操作,比如查找元素、输入搜索关键词等 time.sleep(30) # 关闭浏览器 driver.quit()

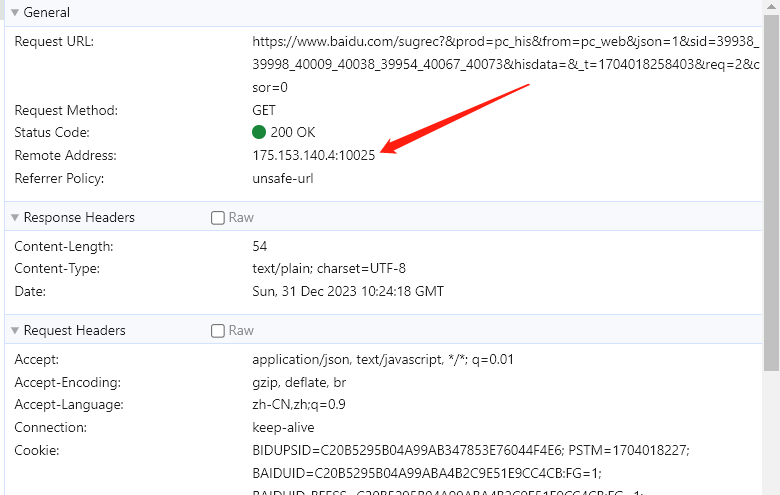

点击测试运行,运行成功,并确认正确使用代理IP:

本文介绍了 Selenium 使用无账号和有账号密码进行代理爬虫的方式,无账号密码主要基于浏览器 --proxy-server 参数实现,而有账号密码的方式基于 Selenium-Chrome-HTTP-Private-Proxy 插件实现;同时分享了一种免费获取代理IP的方式(一连代理),感兴趣的朋友可以试试。

个人简介👋 你好,我是 Lorin 洛林,一位 Java 后端技术开发者!座右铭:Technology has the power to make the world a better place.

🚀 我对技术的热情是我不断学习和分享的动力。我的博客是一个关于Java生态系统、后端开发和最新技术趋势的地方。

🧠 作为一个 Java 后端技术爱好者,我不仅热衷于探索语言的新特性和技术的深度,还热衷于分享我的见解和最佳实践。我相信知识的分享和社区合作可以帮助我们共同成长。

💡 在我的博客上,你将找到关于Java核心概念、JVM 底层技术、常用框架如Spring和Mybatis 、MySQL等数据库管理、RabbitMQ、Rocketmq等消息中间件、性能优化等内容的深入文章。我也将分享一些编程技巧和解决问题的方法,以帮助你更好地掌握Java编程。

🌐 我鼓励互动和建立社区,因此请留下你的问题、建议或主题请求,让我知道你感兴趣的内容。此外,我将分享最新的互联网和技术资讯,以确保你与技术世界的最新发展保持联系。我期待与你一起在技术之路上前进,一起探讨技术世界的无限可能性。

📖 保持关注我的博客,让我们共同追求技术卓越。

我正在参与2023腾讯技术创作特训营第四期有奖征文,快来和我瓜分大奖!